A levél, amelyet több mint kétezren írtak már alá – köztük olyan prominens személyiségek, mint Elon Musk Tesla-vezér vagy Steve Wozniak, az Apple egyik alapítója – hat hónapos szünet tartását indítványozza az MI-rendszerek fejlesztésével kapcsolatban. Ezt egyébként elsősorban az olyan rendszerekre értik, amelyek „erősebbek”, mint a GPT–4 névre hallgató, nyelvi modellek használatán alapuló chatbot.

A nyílt levél azzal érvel, hogy

a GPT–4 képességeit meghaladó MI-rendszerek fejlesztése jelentős kockázatot jelenthet a társadalom számára,

ezért a javasolt hat hónapos „nyári szünetben” ezeket a kockázatokat fel kellene mérni, majd eldönteni, hogy azokat milyen irányban fejlesszék tovább. Erre különböző stratégiák kidolgozását javasolják a szöveg megfogalmazói. A levél megjegyzi továbbá, hogy a szünet segíthet az MI-be vetett közbizalom kialakításában, és biztosíthatja, hogy fejlesztése összhangban legyen a társadalom egészének értékeivel és céljaival. A javaslat nem titkolt célja tehát az emberiség megvédése a nem várt hatásoktól, például a rendszerek esetleges károkozásától, tisztességtelen vagy elfogult használatától.

A nyílt levél komoly kritikát váltott ki számos MI-kutatóból, politikai döntéshozóból és iparági vezetőből. Az egyik fő bírálat az, hogy

nincs semmi konkrét bizonyíték az abban foglalt meglehetősen hipotetikus, bár retorikai szempontból hangzatos állítások alátámasztására.

A levelet kritizálók szerint az MI kockázatai inkább gondos tervezéssel és felügyelettel mérsékelhetők, de emiatt egy szünet bevezetése teljesen szükségtelen és aránytalan intézkedés lenne. Olyan vélemények is napvilágot láttak, amelyek szerint a nyílt levelet csupán kutatók egy szűk csoportja jegyzi, akik nem képviselik a nézetek és perspektívák sokféleségét az MI-közösségben. A levél ezért inkább egyfajta elitista álláspontot képvisel, figyelmen kívül hagyva más érdekelt felek és a nagyközönség hangját és aggodalmait.

A levél mögöttes gondolatát támogatók ezzel szemben úgy érvelnek, hogy a hat hónapos szünet észszerű és arányos válasz az MI kockázataira, és lehetőséget biztosíthat a kutatók számára, hogy kapcsolatba lépjenek más érdekelt felekkel, és stratégiákat dolgozzanak ki az ilyen rendszerek jelentette kihívások kezelésére. Emellett a szünet segíthet az MI-be vetett közbizalom kiépítésében, és biztosíthatja a megfelelő irányú fejlődést.

De hogyan is jutottunk idáig? Fontos hangsúlyozni, hogy a Large Language Model (LLM) elnevezésű, nyelvi modelleken alapuló MI-rendszereket régóta fejlesztik, és azok jó pár éve elérhetők a nagyközönség számára is. Egészen tavaly év végéig ezek a szoftverek a nyilvánosságban nem kaptak különösebb visszhangot, az azokat napi szinten használó vállalatok és szervezetek mellett leginkább csak néhány, a téma iránt érdeklődő szakértő, tudós, techguru vagy IT-blogger beszélgetett róluk, elsősorban szakmai körökben. Majd 2022 végén berobbant a közbeszédbe az Open AI által fejlesztett ChatGPT nevű program, amelyet már rengetegen kipróbáltak azóta. Ennek a legújabb, 2023 márciusában megjelent változata a GPT–4.

A hasonló programok, amelyek megpróbálják utánozni az emberi viselkedést – mint például jelen esetben a nyelvet és az írásbeli kifejezőképességet – az emberi befogadó számára gyakran okoznak úgynevezett Pügmalión-hatást. Az MI-re vetítve ennek a pszichológiai jelenségnek a lényegét úgy ragadhatjuk meg, hogy

ha az emberi megfigyelő túl sokáig foglalatoskodik egy olyan mesterséges entitással, amelynek célja bizonyos emberi tulajdonságok utánzása, egy idő után hajlamos belelátni az emberi mivoltot és tudatosságot.

Alighanem ez történt a Google fejlesztőmérnökével is, aki nyelvi modellek tanításával foglalkozott, majd később a nyilvánosság elé állt, azt állítva, hogy az általa fejlesztett program öntudatra ébredt, lelke van. A Google azóta megvált ettől az alkalmazottjától.

A gép által végzett számítások kimenetelének azonban elsősorban mi, emberek adunk és tulajdonítunk értelmet, a feltételezett jelentés komplexitása miatt látunk bele egyfajta tudatosnak vélt intelligenciát. Az MI ehhez képest nincs tisztában azzal, hogy mit miért csinál, nem tudja kontextusba helyezni az általa hozott döntéseket.

A jelenleg túlsúlyban lévő tudományos álláspont szerint az absztrakt gépi gondolkodásnak nem a mesterséges intelligencia, hanem a mesterséges tudat (artificial consciousness, AC) lenne az előfeltétele, amely viszont nem létezhet önazonosságra és önreflexióra való képesség nélkül. Ehhez a belső állapotra való szakadatlan referenciaképzés és az éppen aktuális külső állapot összevetése is szükséges.

Platón ezt már több ezer évvel ezelőtt úgy fogalmazta meg, hogy a lélek folyamatosan önmagával folytatott hangtalan beszélgetése az, amit gondolkodásnak nevezünk.

Az öntudat kialakulása, fejlődése, az én kiválása a környezet egységéből pedig lassú folyamat. Jacques Lacan francia pszichoanalitikus például a „tükörstádiumhoz” köti a kezdetét, amikor a csecsemők a tükör előtt, saját tükörképükkel szembesülve önfelismerésre utaló reakciókat adnak.

Az FLI nyílt levelében leírt hangzatos, de meglehetősen általános érveknek talán a ChatGPT és a hasonló nyelvi modellek elmúlt szűk fél évben a köztudatba való berobbanása áll a hátterében. A leginkább félelmekre alapuló és nehezen megfogható, általános kockázatok, veszélyek felemlegetése legalábbis erre enged következtetni.

Az MI-fejlesztések leállítását sürgető írásokban tetten érhető az a jelenség, amelyet a „hátborzongató völgy” (uncanny valley) fogalmával írt le először az 1970-es években Maszahiro Mori japán filozófus. Ezek szerint, amint egyre inkább emberszerűbbek lesznek a robotok, úgy nő velük szemben a rokonszenvünk, azonban egy ponton túl, amikor már nagyon emberszerűek, egyszer csak bizarrnak, hátborzongatónak és veszélyesnek látjuk őket.

Félreértés ne essék, az MI fejlesztésének valóban vannak komoly kockázatai, és ezeknek valóban jelentős hatásuk lehet az emberi életre és az alapvető jogokra is. A munkaerő-toborzásban az MI általi önéletrajz-előválogatás például bevett módszer nagyobb vállalatoknál, mégis diszkriminációs kockázatokat hordoz, hiszen több esetben előnyben részesített egyes társadalmi csoportokat másokkal szemben. Hiszen ezt szűrte le azon adatbázis alapján, amelyből tanították.

Ezeknek a kezelésére és felmérésére azonban szintén évekkel ezelőtt elindult már a tudományos diskurzus, továbbá a jogalkotási, szabályozási folyamatok (lásd az uniós tervezetről szóló írásunkat itt).

A levél üzenete tehát azon a ponton mindenképpen ferdít, hogy ezt most kellene elkezdeni, hiszen az már jó ideje folyik.

Abban viszont természetesen mindenképpen egyet lehet érteni a nyílt levéllel, hogy a számítási, problémamegoldási képességben az emberit meghaladó gépi intelligencia megfelelő irányba történő bölcs navigálása a jövő leglényegesebb kihívása. Ez az álláspont az MI-fejlesztés felnőttkorát, a felelős szülő és tanító képét vetítheti előre számunkra.

A szerző jogász, az Adatvédelmi Hatóság osztályvezetője

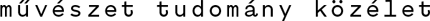

Nyitókép: Elon Musk cégének, a Neuralinknek az emberi agy működését befolyásoló számítógépével 2019-ben

Lásd írásunkat Henry Kissinger és társai MI-könyvéről itt és Z. Karvalics László írását itt, illetve William Hague írását itt